Как посмотреть все файлы сайта

Подходы к извлечению данных из веб-ресурсов

В предыдущей статье мы рассмотрели основные понятия и термины в рамках технологии Data Mining. Сегодня более детально остановимся на Web Mining и подходах к извлечению данных из веб-ресурсов.

Анализ DOM дерева

Этот подход основывается на анализе DOM дерева. Используя этот подход, данные можно получить напрямую по идентификатору, имени или других атрибутов элемента дерева (таким элементом может служить параграф, таблица, блок и т.д.). Кроме того, если элемент не обозначен каким-либо идентификатором, то к нему можно добраться по некоему уникальному пути, спускаясь вниз по DOM дереву, например:

или пройтись по коллекции однотипных элементов, например:

Data Extracting SDK использует Microsoft.mshtml для анализа DOM дерева, но является «надстройкой» над библиотекой для удобства работы:

UriHtmlProcessor proc = new UriHtmlProcessor( new Uri ( «http://habrahabr.ru/new/page1/» ));

proc.Initialize();

Следующим эволюционным этапом анализа DOM дерева является использования XPath — т.е. путей, которые широко используются при парсинге XML данных. Суть данного подхода в том, чтобы с помощью некоторого простого синтаксиса описывать путь к элементу без необходимости постепенного движения вниз по DOM дереву. Данный подход использует всеми известная библиотека jQuery и библиотека HtmlAgilityPack:

HtmlDocument doc = new HtmlDocument();

doc.Load( «file.htm» );

foreach (HtmlNode link in doc.DocumentElement.SelectNodes( «//a[@href» ])

<

HtmlAttribute att = link[ «href» ];

att.Value = FixLink(att);

>

doc.Save( «file.htm» );

Парсинг строк

Несмотря на то, что этот подход нельзя применять для написания серьезных парсеров, я о нем немного расскажу.

Иногда данные отображаются с помощью некоторого шаблона (например, таблица характеристик мобильного телефона), когда значения параметров стандартные, а меняются только их значения. В таком случае данные могут быть получены без анализа DOM дерева, а путем парсинга строк, например, как это сделано в Data Extracting SDK:

Компания: Microsoft

Штаб-квартира: Редмонд

// output

// company = «Microsoft»

// location = «Редмонт»

Использование набора методов для анализа строк иногда (чаще — простых шаблонных случаях) более эффективный чем анализ DOM дерева или XPath.

Регулярные выражения и парсинг XML

Очень часто видел, когда HTML полностью парсили с помощью регулярных выражений. Это в корне неверный подход, так как таким образом можно получить больше проблем, чем пользы.

Регулярные выражения необходимо использоваться только для извлечения данных, которые имеют строгий формат — электронные адреса, телефоны и т.д., в редких случаях — адреса, шаблонные данные.

Еще одним неэффективным подходом является рассматривать HTML как XML данные. Причина в том, что HTML редко бывает валидным, т.е. таким, что его можно рассматривать как XML данные. Библиотеки, реализовавшие такой подход, больше времени уделяли преобразованию HTML в XML и уже потом непосредственно парсингу данных. Поэтому лучше избегайте этот подход.

Визуальный подход

В данный момент визуальный подход находится на начальной стадии развития. Суть подхода в том, чтобы пользователь мог без использования программного языка или API «настроить» систему для получения нужных данных любой сложности и вложенности. О чем-то похожем (правда применимым в другой области) — методах анализа веб-страниц на уровне информационных блоков, я уже писал. Думаю, что парсеры будущего будут именно визуальными.

Проблемы и общие рекомендации

Проблемы при парсинге HTML данных — использование JavaScript / AJAX / асинхронных загрузок очень усложняют написание парсеров; различные движки для рендеринга HTML могут выдавать разные DOM дерева (кроме того, движки могут иметь баги, которые потом влияют на результаты работы парсеров); большие объемы данных требуют писать распределенные парсеры, что влечет за собой дополнительные затраты на синхронизацию.

Нельзя однозначно выделить подход, который будет 100% применим во всех случаях, поэтому современные библиотеки для парсинга HTML данных, как правило, комбинируют, разные подходы. Например, HtmlAgilityPack позволяет анализировать DOM дерево (использовать XPath), а также с недавних пор поддерживается технология Linq to XML. Data Extracting SDK использует анализ DOM дерева, содержит набор дополнительных методов для парсинга строк, а аткже позволяет использовать технологию Linq для запросов в DOM модели страницы.

На сегодня абсолютным лидером для парсинга HTML данных для дотнетчиков является библиотека HtmlAgilityPack, но ради интереса можно посмотреть и на другие библиотеки.

Как узнать список всех файлов на сайте

Есть в сети некий сайт, например www.sightname.com

Как можно получить список всех файлов, находящихся на этом сайте.

Как получить список всех айди на сайте?

нужно получить список всех айпи в сайте а точнее их значение как это сделать помогите к.

Как узнать список всех языков и загрузть их в ListBox

Потскажите, пожалуйста, как можно узнать список всех языков (может есть API-функции), которые есть.

Как узнать список ВСЕХ пользователей и выставить ридонли?

Здравствуйте, ситуация такая: создаю проект, купил сервер, с Ubuntu 12.04 нанял программиста, он.

Как узнать имя и путь всех файлов и подпапок находящихся в папке?

Подсажите как можно узнать имя и путь всех файлов и подпапок находящихся в папке.

Как узнать и скорректировать список файлов стилей, подключаемых функцией APPLICATION->ShowHead()?

На сайте не отображаются стили. Наверное, подключаются по неправильным адресам. Как мне посмотреть.

Есть HWND приложения, как узнать список занятых файлов этим приложением?

Пишу программу на c++ builder. необходимо узнать какие файлы заблокировало приложение, HWND или PID.

Задача стоит такая : вывести на экран список всех файлов в заданной папке, после этого выбрать один.

Как получить список всех файлов в директории и поддиректориях

Требуется сделать метод, который бы возвращал массив всех файлов находящихся в заданной директории.

HackWare.ru

Этичный хакинг и тестирование на проникновение, информационная безопасность

Веб-архивы Интернета: как искать удалённую информацию и восстанавливать сайты

Что такое Wayback Machine и Архивы Интернета

В этой статье мы рассмотрим Веб Архивы сайтов или Интернет архивы: как искать удалённую с сайтов информацию, как скачать больше несуществующие сайты и другие примеры и случаи использования.

Принцип работы всех Интернет Архивов схожий: кто-то (любой пользователь) указывает страницу для сохранения. Интернет Архив скачивает её, в том числе текст, изображения и стили оформления, а затем сохраняет. По запросу сохранённые страницу могут быть просмотрены из Интернет Архива, при этом не имеет значения, если исходная страница изменилась или сайт в данный момент недоступен или вовсе перестал существовать.

Многие Интернет Архивы хранят несколько версий одной и той же страницы, делая её снимок в разное время. Благодаря этому можно проследить историю изменения сайта или веб-страницы в течение всех лет существования.

В этой статье будет показано, как находить удалённую или изменённую информацию, как использовать Интернет Архивы для восстановления сайтов, отдельных страниц или файлов, а также некоторые другие случае использования.

Wayback Machine — это название одного из популярного веб архива сайтов. Иногда Wayback Machine используется как синоним «Интернет Архив».

Какие существуют веб-архивы Интернета

Я знаю о трёх архивах веб-сайтов (если вы знаете больше, то пишите их в комментариях):

web.archive.org

Этот сервис веб архива ещё известен как Wayback Machine. Имеет разные дополнительные функции, чаще всего используется инструментами по восстановлению сайтов и информации.

Для сохранения страницы в архив перейдите по адресу https://archive.org/web/ введите адрес интересующей вас страницы и нажмите кнопку «SAVE PAGE».

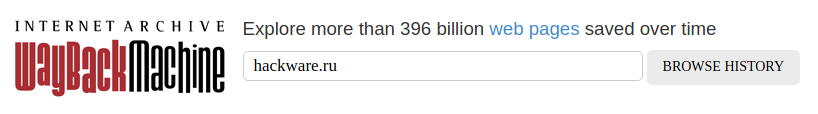

Для просмотра доступных сохранённых версий веб-страницы, перейдите по адресу https://archive.org/web/, введите адрес интересующей вас страницы или домен веб-сайта и нажмите «BROWSE HISTORY»:

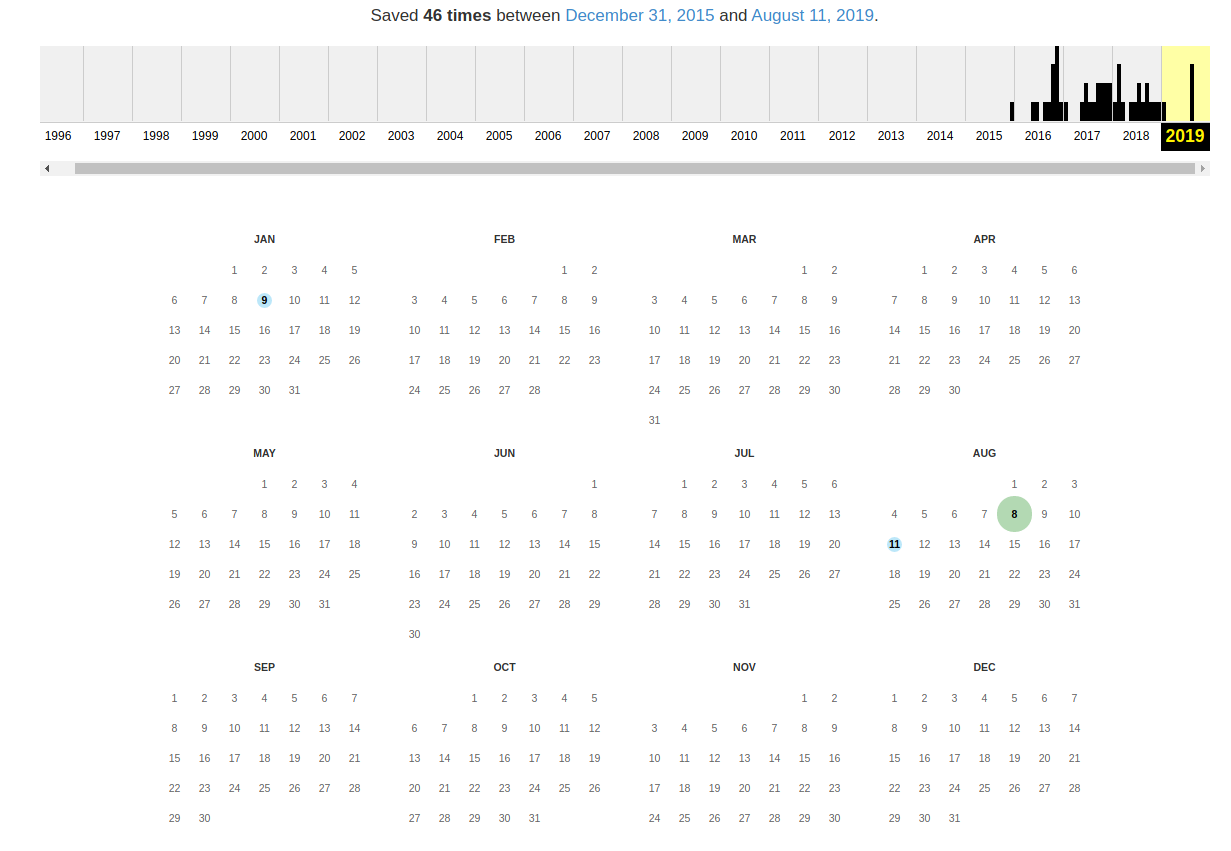

В самом верху написано, сколько всего снимком страницы сделано, дата первого и последнего снимка.

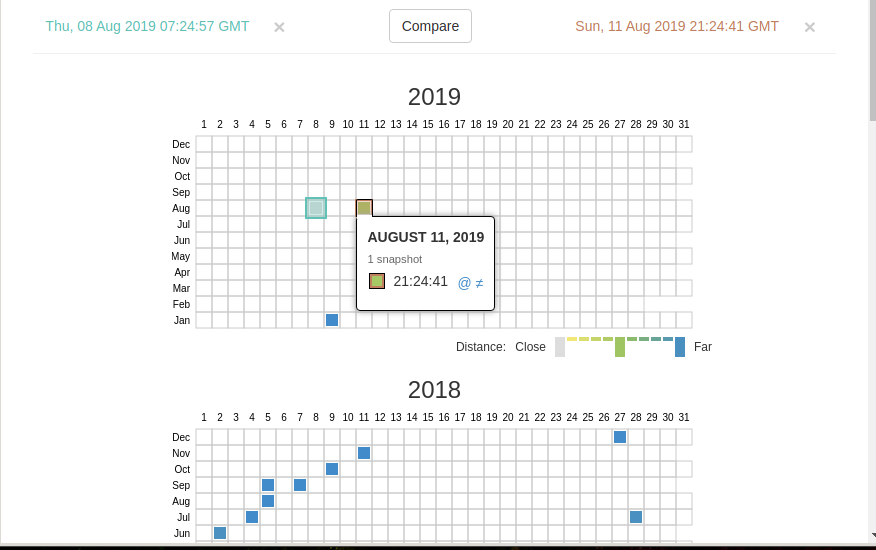

Затем идёт шкала времени на которой можно выбрать интересующий год, при выборе года, будет обновляться календарь.

Обратите внимание, что календарь показывает не количество изменений на сайте, а количество раз, когда был сделан архив страницы.

Точки на календаре означают разные события, разные цвета несут разный смысл о веб захвате. Голубой означает, что при архивации страницы от веб-сервера был получен код ответа 2nn (всё хорошо); зелёный означает, что архиватор получил статус 3nn (перенаправление); оранжевый означает, что получен статус 4nn (ошибка на стороне клиента, например, страница не найдена), а красный означает, что при архивации получена ошибка 5nn (проблемы на сервере). Вероятно, чаще всего вас должны интересовать голубые и зелёные точки и ссылки.

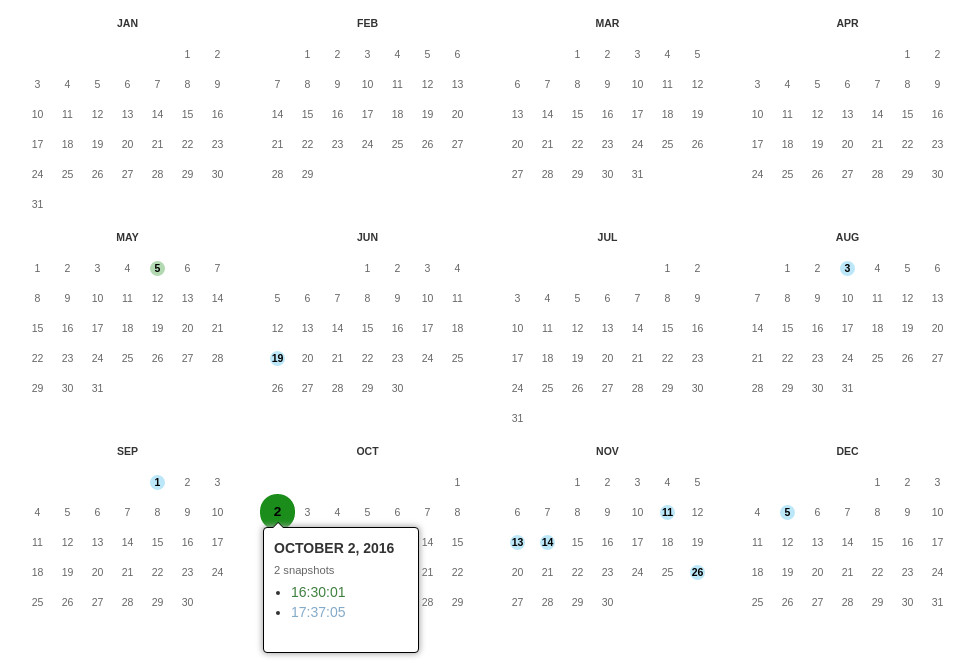

При клике на выбранное время, будет открыта ссылка, например, http://web.archive.org/web/20160803222240/https://hackware.ru/ и вам будет показано, как выглядела страница в то время:

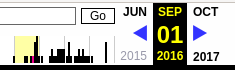

Используя эту миниатюру вы сможете переходить к следующему снимку страницы, либо перепрыгнуть к нужной дате:

Лучший способ увидеть все файлы, которые были архивированы для определённого сайта, это открыть ссылку вида http://web.archive.org/*/www.yoursite.com/*, например, http://web.archive.org/*/hackware.ru/

Кроме календаря доступна следующие страницы:

Changes

«Changes» — это инструмент, который вы можете использовать для идентификации и отображения изменений в содержимом заархивированных URL.

Начать вы можете с того, что выберите два различных дня какого-то URL. Для этого кликните на соответствующие точки:

И нажмите кнопку Compare. В результате будут показаны два варианта страницы. Жёлтый цвет показывает удалённый контент, а голубой цвет показывает добавленный контент.

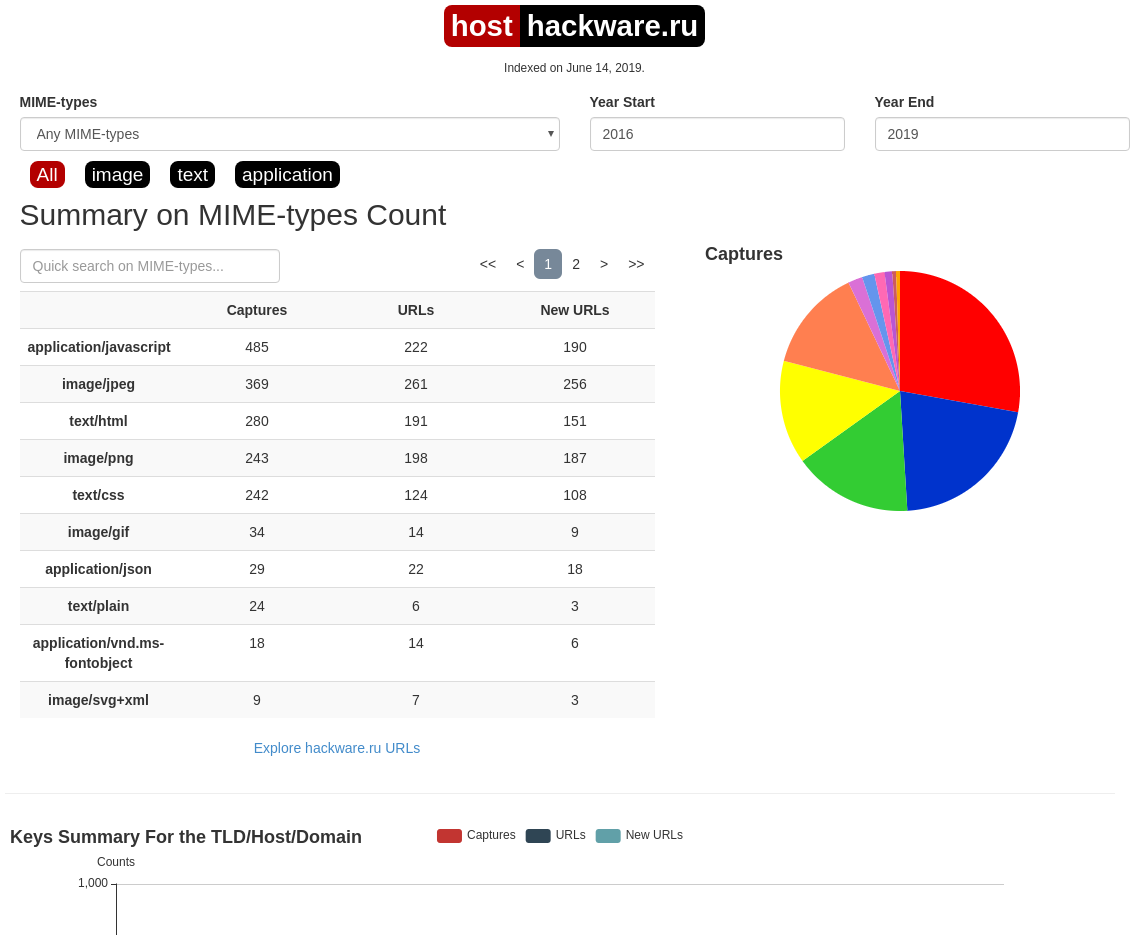

Summary

В этой вкладке статистика о количестве изменений MIME-типов.

Site Map

Как следует из название, здесь показывается диаграмма карты сайта, используя которую вы можете перейти к архиву интересующей вас страницы.

Поиск по Интернет архиву

Если вместо адреса страницы вы введёте что-то другое, то будет выполнен поиск по архивированным сайтам:

Показ страницы на определённую дату

Кроме использования календаря для перехода к нужной дате, вы можете просмотреть страницу на нужную дату используя ссылку следующего вида: http://web.archive.org/web/ГГГГММДДЧЧММСС/АДРЕС_СТРАНИЦЫ/

Обратите внимание, что в строке ГГГГММДДЧЧММСС можно пропустить любое количество конечных цифр.

Если на нужную дату не найдена архивная копия, то будет показана версия на ближайшую имеющуюся дату.

archive.md

Адреса данного Архива Интернета:

На главной странице говорящие за себя поля:

Для поиска по сохранённым страницам можно как указывать конкретный URL, так и домены, например:

Данный сервис сохраняет следующие части страницы:

Не сохраняются следующие части веб-страниц:

Архивируемая страница и все изображения должны быть менее 50 Мегабайт.

Для каждой архивированной страницы создаётся ссылка вида http://archive.is/XXXXX, где XXXXX это уникальный идентификатор страницы. Также к любой сохранённой странице можно получить доступ следующим образом:

Дату можно продолжить далее, указав часы, минуты и секунды:

Для улучшения читаемости, год, месяц, день, часы, минуты и секунды могут быть разделены точками, тире или двоеточиями:

Также возможно обратиться ко всем снимкам указанного URL:

Все сохранённые страницы домена:

Все сохранённые страницы всех субдоменов

Чтобы обратиться к самой последней версии страницы в архиве или к самой старой, поддерживаются адреса вида:

Чтобы обратиться к определённой части длинной страницы имеется две опции:

В доменах поддерживаются национальные символы:

Обратите внимание, что при создании архивной копии страницы архивируемому сайту отправляется IP адрес человека, создающего снимок страницы. Это делается через заголовок X-Forwarded-For для правильного определения вашего региона и показа соответствующего содержимого.

web-arhive.ru

Архив интернет (Web archive) — это бесплатный сервис по поиску архивных копий сайтов. С помощью данного сервиса вы можете проверить внешний вид и содержимое страницы в сети интернет на определённую дату.

На момент написания, этот сервис, вроде бы, нормально не работает («Database Exception (#2002)»). Если у вас есть по нему какие-то новости, то пишите их в комментариях.

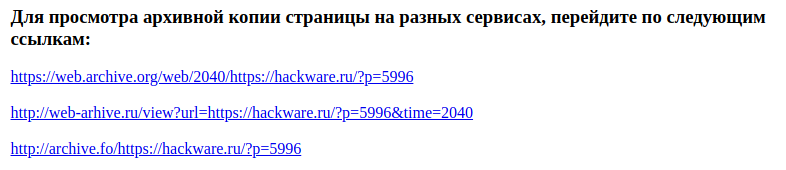

Поиск сразу по всем Веб-архивам

Может так случиться, что интересующая страница или файл отсутствует в веб архиве. В этом случае можно попытаться найти интересующую сохранённую страницу в другом Архиве Интернета. Специально для этого я сделал довольно простой сервис, который для введённого адреса даёт ссылки на снимки страницы в рассмотренных трёх архивах.

Что делать, если удалённая страница не сохранена ни в одном из архивов?

Архивы Интернета сохраняют страницы только если какой-то пользователь сделал на это запрос — они не имеют функции обходчиков и ищут новые страницы и ссылки. По этой причине возможно, что интересующая вас страница оказалась удалено до того, как была сохранена в каком-либо веб-архиве.

Тем не менее можно воспользоваться услугами поисковых движков, которые активно ищут новые ссылки и оперативно сохраняют новые страницы. Для показа страницы из кэша Google нужно в поиске Гугла ввести

Если ввести подобный запрос в поиск Google, то сразу будет открыта страница из кэша.

Для просмотра текстовой версии можно использовать ссылку вида:

Для просмотра исходного кода веб страницы из кэша Google используйте ссылку вида:

Например, текстовый вид:

Как полностью скачать сайт из веб-архива

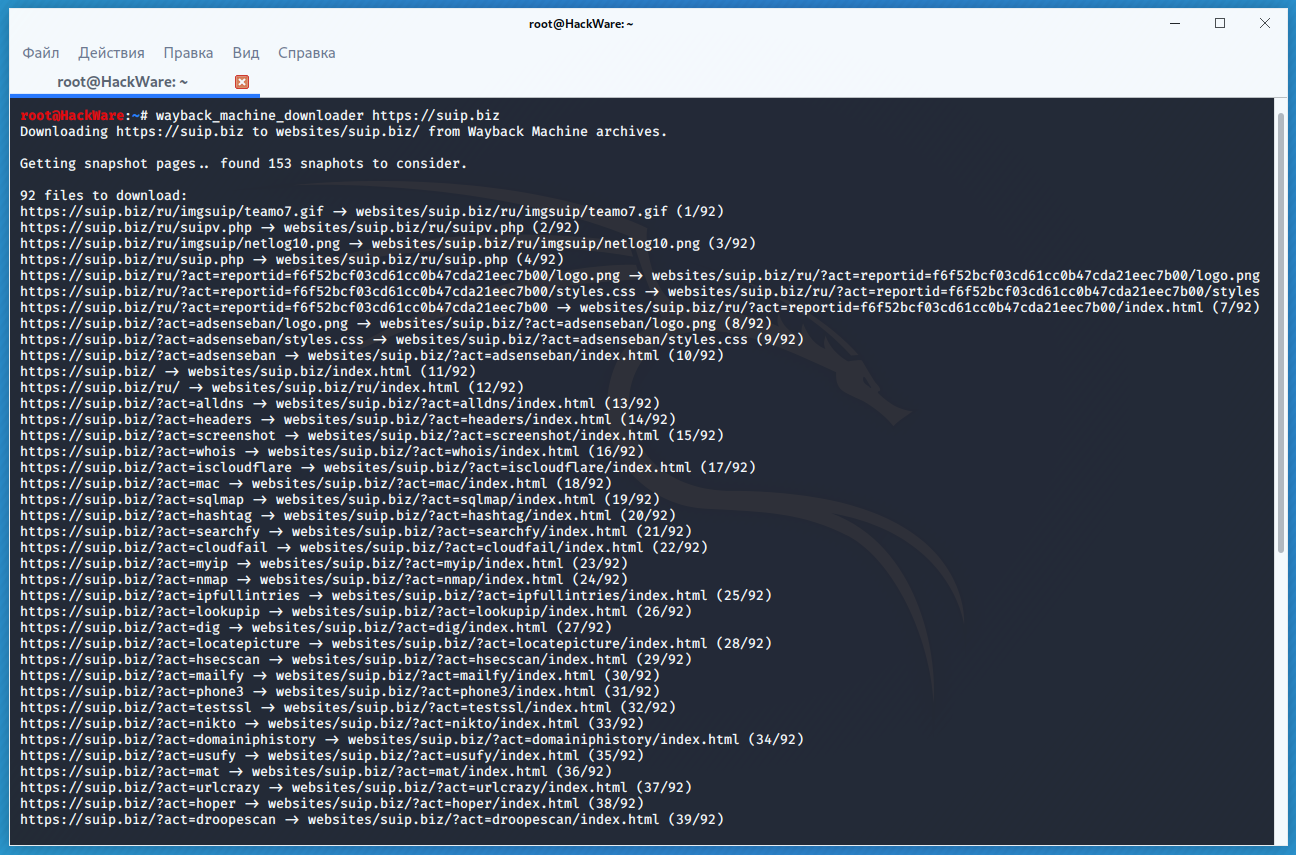

Если вы хотите восстановить удалённый сайт, то вам поможет программа Wayback Machine Downloader.

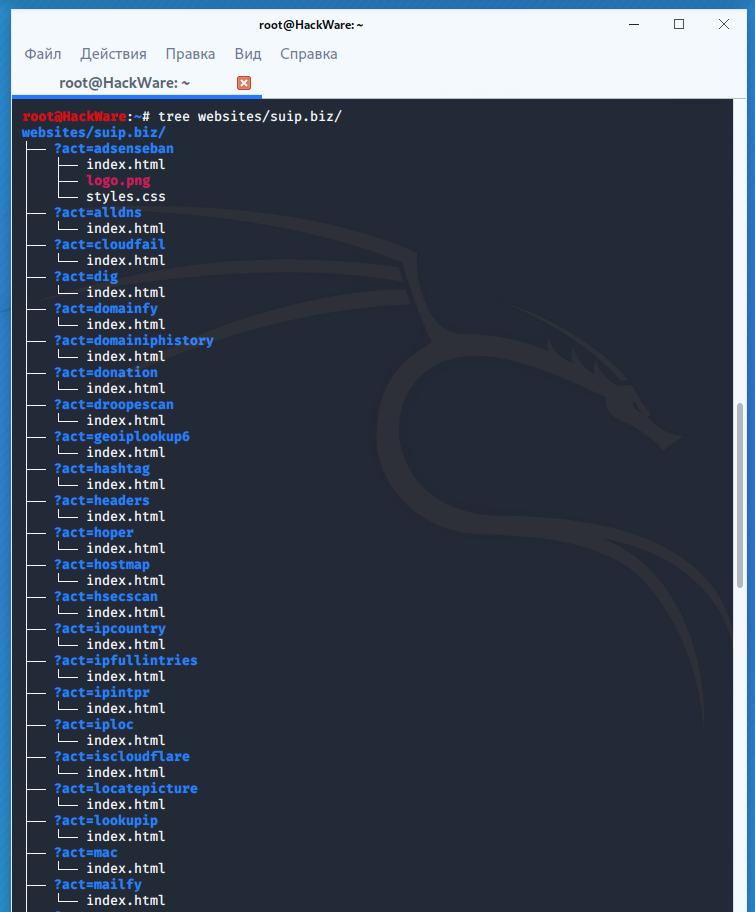

Программа загрузит последнюю версию каждого файла, присутствующего в Архиве Интернета Wayback Machine, и сохранить его в папку вида ./websites/example.com/. Она также пересоздаст структуру директорий и автоматически создаст страницы index.html чтобы скаченный сайт без каких либо изменений можно было бы поместить на веб-сервер Apache или Nginx.

Об установке программы и дополнительных опциях смотрите на странице https://kali.tools/?p=5211

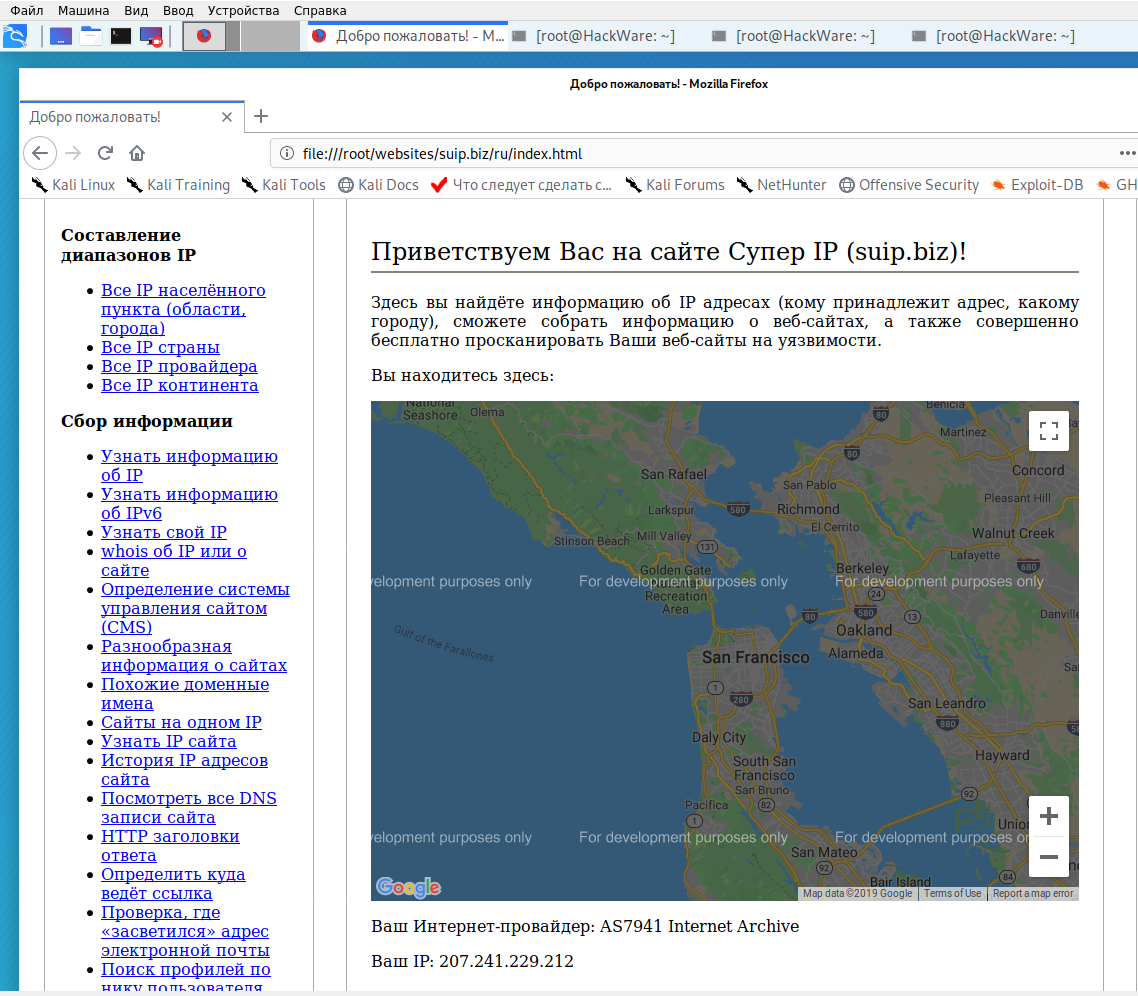

Пример скачивания полной копии сайта suip.biz из веб-архива:

Структура скаченных файлов:

Локальная копия сайта, обратите внимание на провайдера Интернет услуг:

Как скачать все изменения страницы из веб-архива

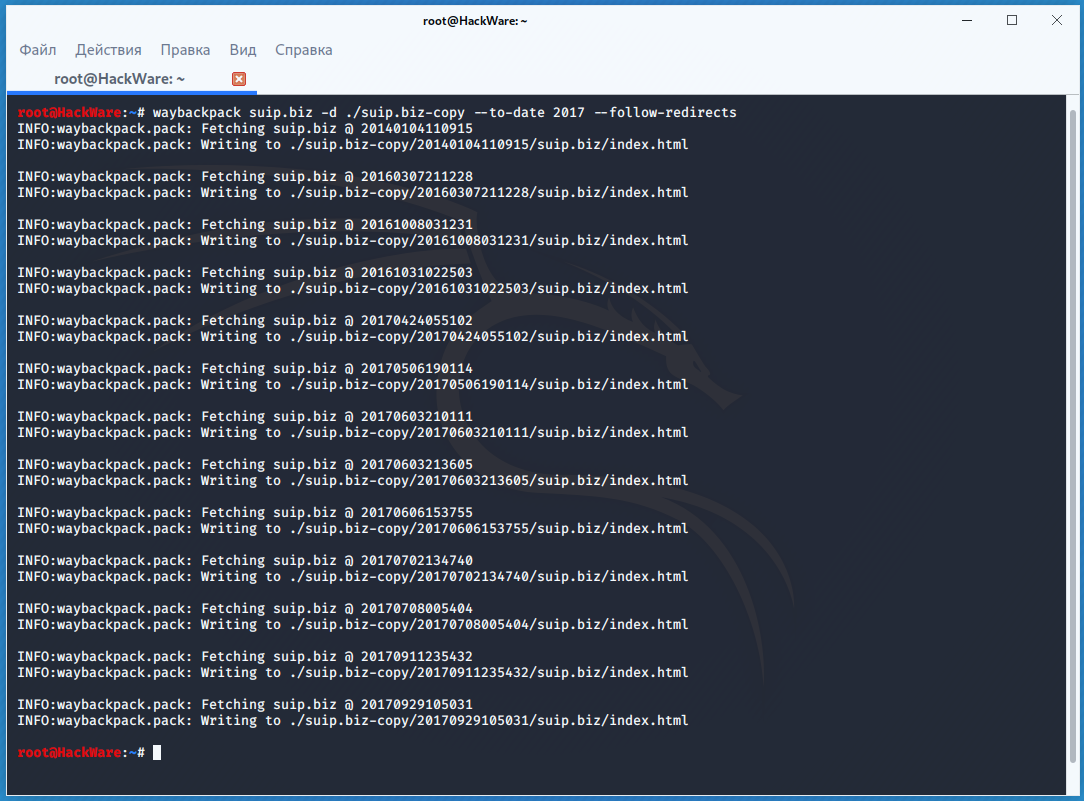

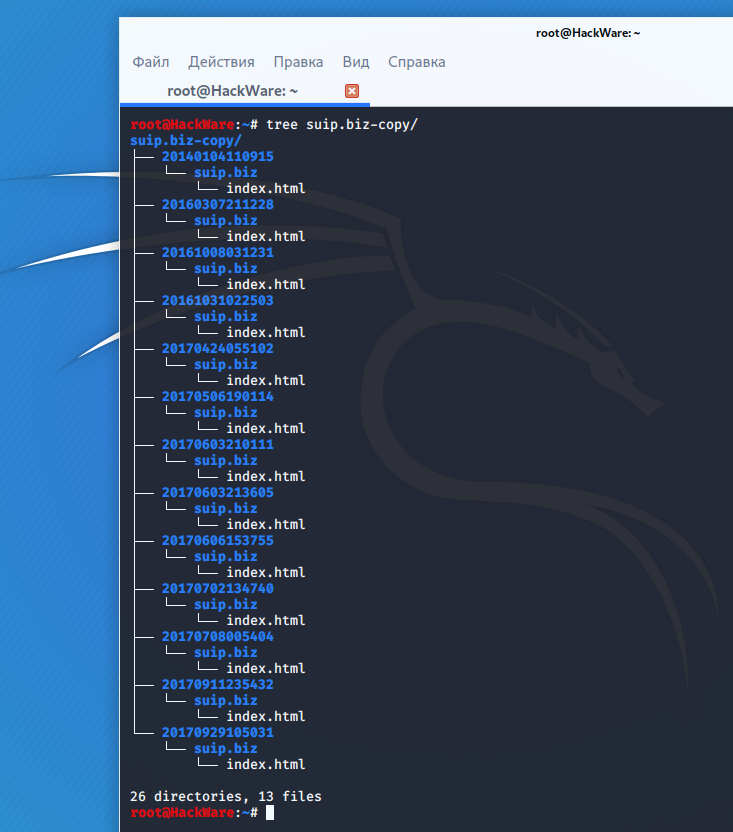

Если вас интересует не весь сайт, а определённая страница, но при этом вам нужно проследить все изменения на ней, то в этом случае используйте программу Waybackpack.

К примеру для скачивания всех копий главной страницы сайта suip.biz, начиная с даты (—to-date 2017), эти страницы должны быть помещены в папку (-d /home/mial/test), при этом программа должна следовать HTTP редиректам (—follow-redirects):

Чтобы для указанного сайта (hackware.ru) вывести список всех доступных копий в веб-архиве (—list):

Как узнать все страницы сайта, которые сохранены в веб-архиве

Для получения ссылок, которые хранятся в Архиве Интернета, используйте программу waybackurls.

Эта программа извлекает все URL указанного домена, о которых знает Wayback Machine. Это можно использовать для быстрого составления карты сайта.

Чтобы получить список всех страниц о которых знает Wayback Machine для домена suip.biz:

Заключение

Предыдущие три программы рассмотрены совсем кратко. Дополнительную информацию об их установке и об имеющихся опциях вы сможете найти по ссылкам на карточки этих программ.

Ещё парочка программ, которые работают с архивом интернета:

Работа с папками и файлами сайта. Навигация в браузере

В данной статье речь пойдет о работе с папками и файлами сайтов построенных на HTML, CSS кодах, размещенных на хостинге провайдера. Она расчитана на минимальные знания будущего вебмастера.

Итак, как уже понятно, сайт состоит из папок и файлов, как все на Вашем компьютере, разница в том, что лежат они удаленно от Вас на компьютере хостинга, который обеспечивает их просмотр в Интернете. Название общей (главной) папки одновременно является наименованием сайта. Допустим имя Вашего сайта sitey.ry, соответственно начальная папка на хостинге, в которой лежат все остальные файлы и папки, называется также sitey.ru.

Как правило, начальной страницей сайта является файл index.html, который лежит в начальной папке с именем сайта. Браузеры так устроены, что видят этот файл заранее и автоматически открывают его из папки. Допустим адрес сайта https://sitey.ru/ и https://sitey.ru/index.html для браузера одинаковы. Это относится также к файлам других расширений: index.php, index.cgi и т.д. В связи с этим файлы index (язык html) чаще являются главной страницей сайта, с которой происходит перенаправление по другим страницам, т.е. файлам с любым названием: page1.html, page2.html и подобные. Ссылки на другие страницы имеют вид: Другая страница из них состоит меню сайта.

Смотрите титульную картинку.

Главное, что Вам стоит уяснить для себя, это то, что браузер открывает файлы по адресу (месторасположение) где они лежат. Например адрес http://sitey.ry/images/1.jpg говорит отом, что откроется картинка 1.jpg, лежащая в папке images, а та в свою очередь лежит в папке сайта sitey.ru и соответственно он откроет эту картинку. Введенный в браузер адрес https://sitey.ru/down/page1.html откроет файл, лежащий в папке down, которая в свою очередь лежит в папке sitey.ru (Ваш сайт).

Эксперимент навигации по папкам:

Открываем, допустим, страницу сайта Man1.ru видеоуроки: http://man1.ru/videolessons/page/8/

При редактировании шаблона обращайте внимание на ссылки по размещению картинок: в них точно указана папка в которой лежит изображение, иначе бы оно не отображалось.

Следите и правильно указывайте ссылки на папки и файлы в них, от этого зависит правильная навигация по страницам сайта.

Проще сначала отредактировать шаблон (создать сайт) с имеющимися названиями, подстраивая под них имена своих изображений, а уже потом используя поиск и замену в текстовом редакторе, оптом заменять названия.

Автор: Саков | Просмотров: 11 807 | 2012-04-20

Как просмотреть содержимое папки сайта в браузере

Добрый день участникам форума.

Как просмотреть содержимое папки на FTP сервере

Всем доброго дня! Разобрался с подключением к FTP серверу. Подскажите 1) Как просмотреть.

Здравствуйте, подскажите пожалуйста, как в Lazarus просмотреть все файлы, имеющиеся в директории.

Как в отладчике просмотреть содержимое списка?

Python 2.7.2. Имеется скрипт, считывающий данные из внешних файлов и определенным образом их.

Как в VBA просмотреть содержимое папок?

Как в VBA просмотреть содержимое папок, типа dirlistbox есть что-нибудь??

Если в ней лежит папка Петя, а пете еще htacces, то правила из папки вася отменяются и берутся из пети для пети всех кто в пете)))

Положил я, вообщем, файлик в папку www. (Весь путь Z:\home\mysite\www\1). Набираю в браузере mysite, получаю Index of/ и вижу папку 1. Кликаю на нее и все равно получаю index.html. Заблудился в трех соснах, вообщем. Что еще можно придумать?

##

## Данный файл может располагаться в директории любого виртуального хоста.

## Любую из директив можно не указывать, тогда берется значение по умолчанию.

## Не пропустите ведущий символ «#» перед директивами.

##

? Или здесь идет речь про какие-то другие директивы?

. Я убрал символ # из файла, но все равно куда бы я файл не положил (в папку mysite, в папку www или просто в папку 1) на странице Index of/ я вижу только содержимое папки www; содержимое папки 1, которое я хочу увидеть, я не вижу. При кликании на папку 1 на странице Index of/ сразу вижу содержимое index.html (один из файлов, лежащих в папке 1).

минус ознаяает запретить, плюс разрешить. Может у вас там еще какие то правила, показывайте тогда все htaccess которые имеете по дереву.

Добавлено через 3 минуты

RamblingBeard, Я не знаю, что у вас после вшего комменария идет, может у вас там список и имеется ввиду отключить что то